Plus de données = plus d’intelligence ? Pas vraiment.

En data science, on a souvent le réflexe d’ajouter des variables. Plus de colonnes, plus de capteurs, plus d’indicateurs… L’intuition semble logique : plus on observe, plus on comprend. Pourtant, c’est souvent l’inverse qui se produit.

Dès que l’on ajoute trop de dimensions, le problème change de nature. Dans un espace simple, à deux ou trois dimensions, il est facile de parler de proximité ou de similarité entre des données. Mais à mesure que les dimensions augmentent, tout devient “loin” de tout. Les points se dispersent et les distances perdent leur sens. Résultat : les algorithmes ont beaucoup plus de mal à trouver des structures claires ou des regroupements.

Le piège des variables corrélées

Un autre problème vient du bruit, qui augmente avec chaque nouvelle variable. Mais ce n’est pas tout : beaucoup de variables sont en réalité corrélées entre elles. C’est comme écouter plusieurs instruments qui jouent exactement la même mélodie : le son est plus fort, mais il n’y a pas plus d’information. Dans les données, ces répétitions ne sont pas toujours visibles. Ce ne sont pas forcément deux colonnes identiques, mais souvent des variables qui racontent presque la même chose. Elles sont présentes partout, et si on ne les repère pas, on croit ajouter de l’information alors qu’on ajoute surtout du poids inutile. Sans les traiter, on finit par complexifier les modèles sans améliorer leur pertinence.

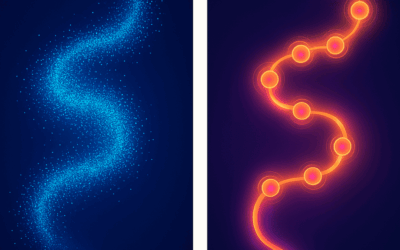

Les séries temporelles, un cas particulier

Les séries temporelles amplifient encore ce phénomène. Suivre une seule variable dans le temps, c’est déjà ajouter une dimension : le temps. Mais lorsque l’on suit des dizaines de capteurs, parfois à la seconde près, on se retrouve avec un gigantesque tableau où beaucoup de courbes évoluent presque en parallèle. Ignorer ces corrélations, c’est prendre le risque de construire des modèles qui apprennent les répétitions et le bruit local, au lieu de comprendre les vraies régularités.

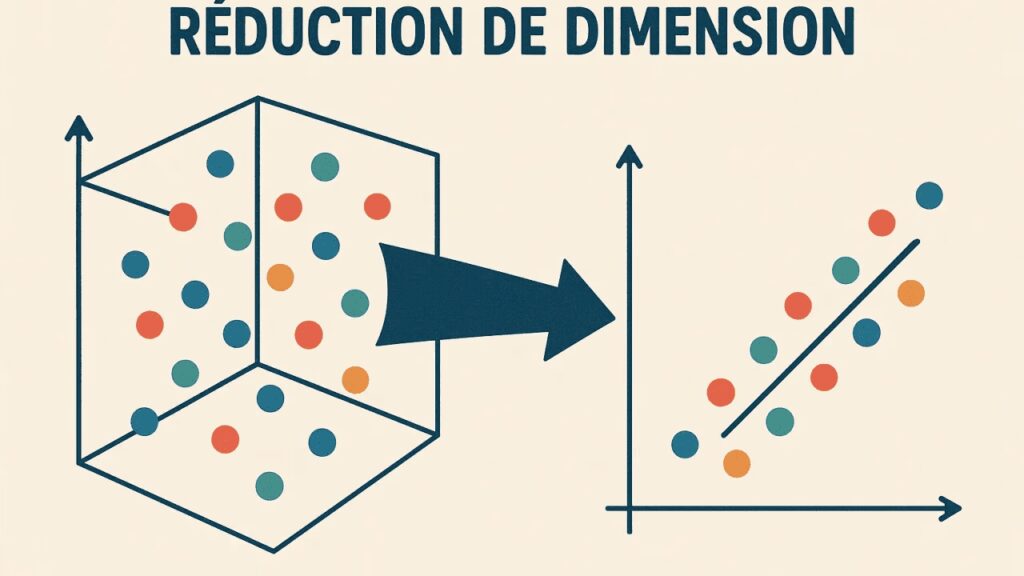

Les outils pour simplifier intelligemment

Heureusement, il existe des solutions. Les méthodes de réduction de dimension, comme la PCA (analyse en composantes principales) ou UMAP, exploitent justement ces corrélations. Elles condensent l’information : si plusieurs variables racontent la même histoire, on les résume en une dimension plus claire. C’est comme passer d’un orchestre brouillon à une partition harmonisée où l’on distingue enfin la mélodie principale.

Ce que ça change pour vos projets

Pour les projets clients, cette approche est essentielle. Elle permet d’alléger les modèles, de réduire les coûts de calcul, mais surtout d’améliorer la lisibilité des résultats. Dans un port, une usine ou une supply chain, on ne veut pas un modèle qui mémorise tout : on veut un modèle qui comprend ce qui compte vraiment pour prédire, anticiper et optimiser. Identifier les variables qui font sens, condenser les données temporelles et mettre en avant le signal utile, c’est la clé pour transformer une masse brute de données en véritables décisions opérationnelles.

Simplifier sans trahir

En fin de compte, plus de données ne signifie pas plus d’intelligence. La véritable valeur se trouve dans la capacité à déceler les corrélations, à distinguer le signal du bruit, et à simplifier sans trahir. Dans les séries temporelles comme ailleurs, la clé n’est pas d’empiler toujours plus, mais de condenser intelligemment ce qui compte vraiment.